Bootcamp: da OS X a Windows per il “superior hardware”

Dopo aver lasciato sbizzarrire gli hacker in complicate conversioni, per portare OS X su PC, Apple ha rilasciato ieri Bootcamp, un “invertitore di flusso” per il mercato hardware, più che software. Cosa significa “invertitore di flusso”? Ci torneremo in seguito. Per ora limitiamoci a capire a cosa serve Bootcamp: semplicemente, si tratta di un’utility grafica che semplifica il lavoro di ripartizionamento del disco di un Mac Intel, automatizzando nel contempo la creazione di un cd di driver tramite il quale diventa possibile installare Windows XP sulle nuova macchine Apple, senza troppi problemi. Basta armarsi di un cd di installazione originale di Windows XP, un cd vergine sul quale masterizzare i driver, lanciare Bootcamp e alla fine riavviare il computer: l’utente si ritroverà con un sistema dual boot OS X/Windows XP, praticamente il sogno di molti che ancora non vogliono acquistare un Mac per paura di abbandonare un sistema operativo ben conosciuto e familiare come quello di Microsoft. Da notare che Bootcamp è disponibile per ora in forma di beta gratuita liberamente disponibile, ma sarà integrato nella prossima release di OS X, denominata Leopard e questo lascia pensare a qualcosa più di una semplice helper utility, buttata lì quasi casualmente.

Ma tutto questo, giova veramente e solamente all’utente?

Proviamo a compiere due riflessioni senza rete.

E’ interessante richiamare alla mente la strategia di posizionamento di Apple nella catena di valore che definisce la redditività di un prodotto di largo consumo come iPod: dalla creazione, alla distribuzione, alla fornitura di contenuti digitali, tenuta alla briglia dal DRM applicato ai prodotti iTunes, quasi tutta la filiera è saldamente nelle mani di Apple. Indubbiamente ciò è un bene per l’utente finale: Apple ricava a ogni passaggio un piccolo guadagno e il prezzo di ogni singolo stadio si attesta su valori tutto sommato bassi. E’ l’azione sinergica dovuta al possesso dei vari anelli della catena del valore a consentire che ogni step sia poco oneroso, garantendo nel contempo un buon guadagno complessivo del prodotto iPod, visto come unione fra prodotto materiale e contenuti multimediali offerti dallo stesso player, la casa di Cupertino.

A ben vedere, si tratta della stessa strategia perseguita nel tempo da Apple anche con i prodotti Mac: chiusura verso l’esterno, hardware proprietario, sistema operativo proprietario. Ma questa non ha avuto la stessa fortuna incontrata da un prodotto tutto sommato a basso costo e dall’acquisto compulsivo quale è l’iPod. E basta ritornare al 1997 per sentire Michael Dell suggerire la sua soluzione alla crisi profonda nella quale Apple versava in quegli anni: chiudere l’azienda e restituire i soldi agli azionisti.

Si era al culmine di una parabola discendente, di un meccanismo di produzione di valore negativo, fallito, rimasto confinato in una nicchia di utenti per lo più “creativi”, certo non di massa, tant’è che solo nel 2000 Jobs riesce a recuperare una situazione finanziaria critica e a ridare fiato all’azienda con l’introduzione dell’iPod, ma siamo nel 2001.

Di massa era sicuramente Windows, un sistema tutto sommato sul limine opposto a quello di Apple: un sistema operativo per nulla integrato con la soluzione hardware pilotata, aperto alle incursioni di produttori di ogni dove.

Il risultato? Computer meno costosi, sistema operativo estremamente diffuso, apertura di Microsoft sul fronte delle applicazioni. Non c’è da nascondersi che il fatto di produrre un sistema operativo avvantaggi chi sia intenzionato a scrivere delle applicazioni per questo sistema e Office è la maggior fonte di rendita per Microsoft: è ovunque, utilizzato da chiunque, per qualunque scopo. Ovviamente generalizziamo, ma è una generalizzazione che rende l’idea.

Se Office è la principale fonte di guadagno di Microsoft, più di Windows stesso, nelle sue varie forme, quale è il peso della strategicità dello scrivere o possedere il sistema operativo sul quale questo risiede?

Non sfugge certo il tentativo di Microsoft di spostate parte del business su Live, la piattaforma che centralizzerà gli applicativi e i dati da essi prodotti sui server remoti gestiti da Microsoft stessa. Progetto inseguito da molto tempo, ma che solo l’avvento del broadband diffuso ha consentito di rendere un’idea praticabile, spostando la produttività dal computer periferico, fondamentalmente incontrollabile, a una sorgente di erogazione di servizi remota, centralizzata, maggiormente controllabile.

Il sistema operativo si sta lentamente “virtualizzando”, diventando accessorio rispetto alle applicazioni, ai programmi, che siano dedicati alla produttività d’ufficio, alla gestione delle email, ai giochi ormai molto diffusi online.

E veniamo all’hardware. I Core Duo di Intel non sono una prerogativa esclusiva di Mac e gradatamente, senza troppo clamore, nelle fasce più alte di prodotto, soprattutto per i notebook, stanno arrivando i nuovi processori Intel, associati ai chip di Trusted Computing.

Ma cosa frena gli utenti dal prendere OS X funzionante su processore INTEL e portarlo sulle piattaforme PC dotate dello stesso tipo di CPU? Nulla, in effetti già qualcosa è stato fatto aggirando la protezione dei chip TC presenti, finora sfruttati al minimo delle loro potenzialità.

Prendendo la palla al balzo, però, Apple inverte i termini del gioco: perché portare OS X su PC, quando è Windows che può essere fatto scivolare senza problemi dentro un Mac Intel?

Lo scambio dei fattori, a ben vedere, è molto più redditizio. Non è il portare un sistema software “sconosciuto” su una piattaforma hardware familiare ad ampliare la base di mercato, ma è proprio il contrario, cioè portare un sistema operativo familiare su una piattaforma hardware sconosciuta.

A ben vedere, portare OS X su PC non ha né molto senso nè grandi vantaggi: la piattaforma Mac ha sempre goduto di buone prestazioni e affidabilità proprio per la forte compenetrazione fra sistema operativo e hardware, entrambi in mano ad Apple e quindi ben conosciuti e ben sfruttati. Muovere qualche passo nel mondo dei PC costringe a inerpicarsi in quella babele di periferiche, schede e processori che hanno reso si molto diffuso Windows ma ne ha anche limitato le prestazioni e inficiato la stabilità.

OS X, in fin dei conti, non ne avrebbe molto da guadagnare soprattutto se si tiene conto degli sforzi compiuti da Apple per accreditare i propri computer come oggetti di qualità, facili da utilizzare e costruiti con materiali di buona fattura.

Ha maggior senso l’operazione inversa: portare gli utenti Windows dalle piattaforme hardware PC a Mac.

Perché? Sostanzialmente per eliminare un gap sostanziale che ostacola la diffusione di OS X, ovvero la diffidenza di quegli utenti che sono nati in Windows e cresciuti con le sue applicazioni. Chi si butterebbe a corpo libero in un sistema operativo sconosciuto, con il timore di non ritrovarvi le applicazioni di sempre?

Lungi dal pensare all’utente avanzato, Apple ha a che fare con il cliente che utilizza il computer prima ancora di comprenderlo, che lo accende e vi ritrova quelle applicazioni che è solito utilizzare. Questi possono essere portati a OS X essenzialmente con due operazioni sinergiche:

- Con la riaffermazione dell’immagine di prodotto. Mac è semplice, Mac è user friendly, Mac funziona e non ha schermate blu, rosse o verdi. Mac è, dopo il successo di iPod, ancora più trendy, definisce uno stile di vita, un’immagine di sé, veicolata dal prodotto, vincente. Determina una identità di appartenenza a un gruppo connotato da forti attributi positivi e di integrazione sociale;

- Rassicurazione dell’utente. In OS X si possono ritrovare le applicazioni che vengono utilizzate in Windows. E se non vi sono, ora diventa possibili tenere Windows su Mac, accanto a OS X, e utilizzare uno o l’altro, forse il meglio di uno e dell’altro.

La transizione, quindi, può non solo completarsi, ma, aspetto più interessante, può iniziare.

L’utente è blandito e rassicurato, viene traghettato in una immagine positiva e nel contempo non è costretto ad abbandonare il mondo di riferimento, un po’ come un bambino che muova i primi passi attaccato alla gonna della madre.

Cosa ci guadagnerebbe Apple? Sicuramente inizierebbe a traghettare nel proprio mondo tutti quegli utenti curiosi, interessanti, ma poco disposti ad abbandonare un sistema operativo, o meglio una serie di applicazioni, utilizzate quotidianamente, a casa come in ufficio.

Altrettanto sicuramente, porterebbe questi utenti a conoscere OS X, visto che Windows XP si installerà solo come secondo sistema operativo, lasciando presente e attivo il sistema nativo Apple.

Infine, porterebbe i clienti a scoprire la qualità dell’hardware Apple, definito nelle parole di Philip Schiller, senior vice president del Worldwide Product Marketing di Apple “superior hardware”, che quindi sarà “more appealing to Windows users considering making the switch”.

Ma a discapito di chi andrà questa transizione? Di Microsoft? Difficile a dirsi. Certo è che se si vogliono cogliere segnali di nervosismo, questi andrebbero, per ironia, attribuiti a Dell, che ha appena acquisito Alienware, azienda specializzata nella produzione di computer che, non a caso, costituisce in parte un omologo di Apple nel mondo dei PC: crea hardware di qualità e computer dall’aspetto molto curato.

Microsoft, dal canto suo, può tutto sommato rimanere a guardare: il proprio sistema operativo inizia un viaggio su piattaforme del tutto nuove, mentre proprio lì dove finora arrivava con difficoltà, nel mondo Apple, ora può entrare a pieno titolo, con le proprie applicazioni in modalità nativa. Se, poi, dovesse perdersi il sistema operativo lato consumer, non è su quello che si crea business, ma su Office, che già ora sta guardando a nuovi orizzonti, lasciandosi dietro i vecchi PC “disconnessi”.

E così Apple arriverebbe a coronare un vecchio sogno, ovvero arrivare a controllare la catena di produzione del valore associata ai computer, strategia riuscita con iPod, assolutamente fallita con i Mac, non tanto per una questione di controllo, quanto per una resa produttiva inficiata dai numeri finora troppo bassi.

Di sfuggita, potremmo accennare a un nuovo problema: con l’avvicendamento di nuovo hardware pare ridursi la fetta di computer privi dei nuovi chip dedicati al Trusted Computing. DRM e TC, due facce della stessa medaglia, paiono essere i leitmotiv dell’industria dei prossimi anni, impegnata a gestire, salvaguardare e ottimizzare la gestione dei contenuti sulle piattaforme end user, decidendo chi può fare cosa, dove e quando.

Cosa fare se il mercato pare imprimere una decisiva svolta in questa direzione? Ci ritroveremo, come per i monitor LCD, senza più la possibilità di scegliere computer non TC? Già, perché basta andare in un qualsiasi centro commerciale per accorgersi che è il mercato dei computer a formare la domanda e non viceversa: provate a cercare un vecchio monitor a tubo catodico. Semplicemente, non se ne fanno più.

E quando non si faranno più computer privi di TC e DRM? Dovremo iniziare a pensare in termini di Hardware Libero? Difficile. Se nel mondo del software la creatività è affiancata da un ridotto costo materiale, nella sfera dell’hardware il discorso cambia radicalmente. Una scheda madre va ingegnerizzata, realizzata in prototipi, provata per poi essere messa in produzione su una linea di gestione appositamente attrezzata. E tutto questo richiede investimenti non comparabili con quelli richiesti per lo sviluppo di un progetto unicamente software.

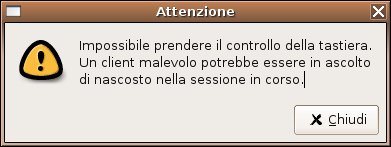

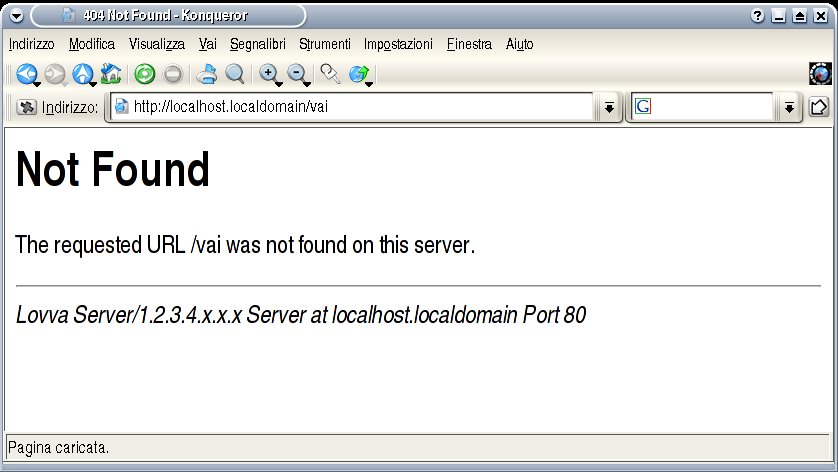

C’è chi riduce la questione dei DRM a una semplice questione di interoperabilità, tesi interessante ma fuorviante, e chi tenta di far passare il Trusted Computing come strumento essenziale per combattere virus, troiani e malware in generale.

Ma chi ha da guadagnarci in tutto questo?

L’utente, tutto sommato, ben poco. Su gnuvox trovate una serie di link utili a risorse per approfondire i problemi legati ai DRM.

Il mercato ha tutto da guadagnarci, rafforzando il controllo sui “contenuti”, nuova parola d’ordine per il futuro prossimo venturo.

E quando non avremo più scelta? Dove vorrete andare, domani?